Tutto sul ray tracing e il suo impatto sull’estetica dei videogiochi

Ritornato prepotentemente alla ribalta lo scorso anno grazie alla presentazione delle schede video NVIDIA RTX durante la Gamescom, il ray tracing si è trasformato (anche se in una forma più embrionale e sotterranea lo è sempre stato) nel feticcio tecnologico che tutti desiderano e di cui tutti parlano.

D’altra parte, la capacità di stupire e ammaliare il videogiocatore con i più recenti prodigi della tecnica è un obiettivo che l’industria videoludica ha sempre perseguito. E se attualmente tale tecnologia è appannaggio dei soli giocatori PC, l’avvento della prossime generazione di console apre scenari piuttosto interessanti (e universali) in tal senso: confermato il supporto di PS5 e della prossima Xbox al ray tracing da parte di Microsoft e Sony, l’illuminazione fotorealistica è più vicina che mai ed è pronta a trasferire su schermo la complessità visiva della realtà che ci circonda. O almeno, a effettuare quell’ulteriore e decisivo passo in avanti in termini di simulazione in tempo reale del comportamento della luce in uno scenario tridimensionale.

Quando “nasce” il ray tracing?

Scoperto nel 1979 da Turner Whitted, l’algoritmo di ray tracing ebbe il merito di approfondire lo studio della corretta riproduzione dei raggi luminosi rispetto ai precedenti algoritmi finora elaborati: se quest’ultimi, come il ray casting, si limitano a calcolare il raggio che dall’occhio/telecamera procede verso una scena (un raggio per ogni pixel mediante un tracciamento inverso rispetto al normale percorso sorgente→osservatore); il ray tracing, dalla sua, espande questo processo catturando anche gli effetti di riflessione, rifrazione e le ombre che si generano quando un raggio colpisce, attraversa o viene bloccato da una superficie caratterizzata da una sua specifica proprietà materiale. Le informazioni acquisite vengono successivamente utilizzate per regolare i livelli di illuminazione e il colore del pixel finale, donando così un maggiore grado di realismo alle immagini mostrate su schermo.

Al fine di evitare di dover tenere traccia di tutti i raggi presenti in una determinata scena, Whitted propose di utilizzare un raggio ombra per stabilire quali oggetti risultassero visibili o meno all’osservatore in modo tale da poter escludere i segmenti non ricevuti dal calcolo computazionale finale. Escludere il non visto, l’invisibile in sostanza, per alleggerire la procedura.

La nota dolente risiedeva nell’alto livello di risorse, in termini di potenza e di tempo, richieste per il rendering. Un limite che ha reso l’utilizzo del ray tracing, almeno fino a poco fa, una prerogativa della sola industria del cinema. La quale, infatti, renderizza tutto nelle sue render farm senza vincoli temporali e senza l’obbligo di dover svolgere i calcoli in tempo reale. Al contrario di ciò che avviene per i videogiochi, ad esempio.

Il presente (e il futuro) estetico è ibrido

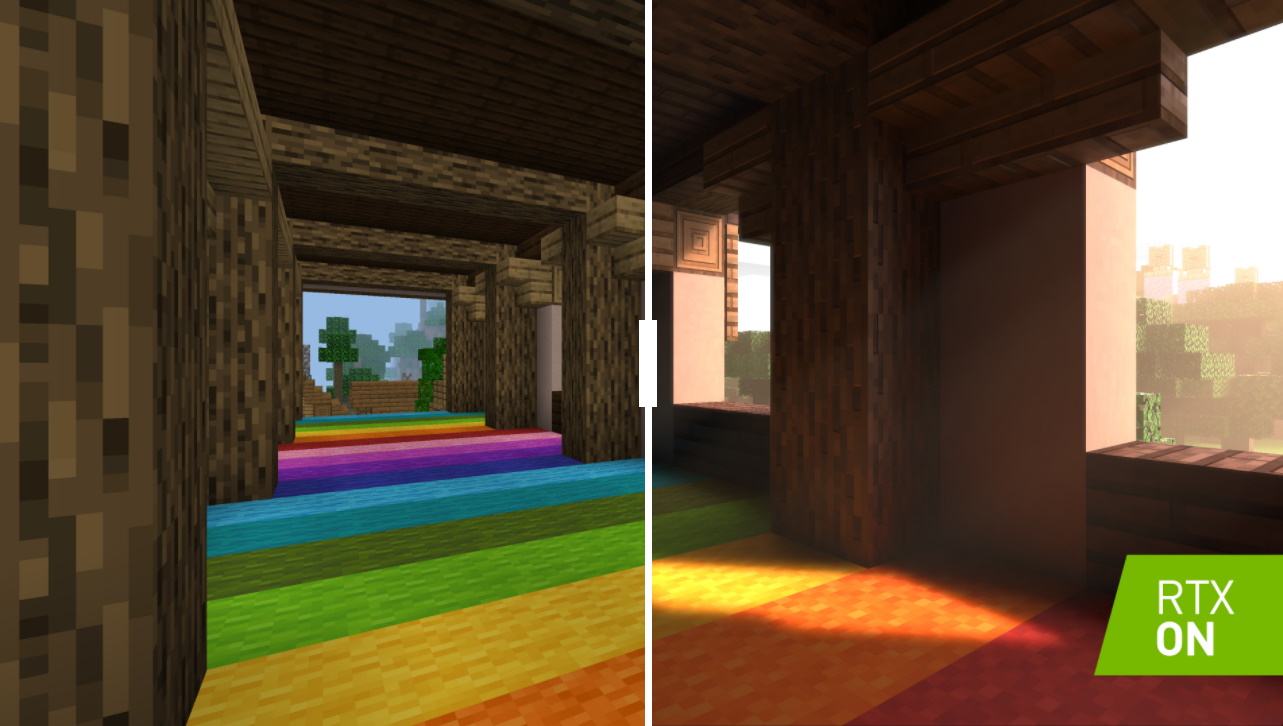

Infatti, nonostante la sfida lanciata da NVIDIA con le RTX (GPU che presentano unità di calcolo dedicate esclusivamente a questa tecnologia) e l’impegno assunto dalle altre aziende del settore, anche adesso quando parliamo di ray tracing applicato ai videogiochi in realtà ci riferiamo a un rendering ibrido. Ovvero, a un utilizzo parziale del ray tracing nell’impossibilità di poterlo applicare in tempo reale per renderizzare l’interna scena di gioco. Possono esserci titoli che usano il ray tracing per gestire l’illuminazione globale esterna, ma non le fonti locali; altri che lo usano per i soli effetti legati alle ombre o per simulare i riflessi su alcune superfici riflettenti come le pozzanghere.

Proprio l’RTX, infatti, sfrutta la rasterization, il ray tracing e un’intelligenza artificiale per avere il suo corredo ibrido. La rasterization altro non è che il processo dietro al rendering 3D per come lo conosciamo dai primi anni Novanta in poi; l’intelligenza artificiale presente, invece, basata sul deep learning mette una toppa ai limiti del portato informazionale del ray tracing generando artificialmente dei pixel al suo posto. Un supporto che si rende necessario per sopperire alla mancanza di forza bruta delle schede video oggi in commercio.

L’ibridazione, di conseguenza, non solo permette di ampliare il bagaglio delle soluzioni in nostro possesso rispetto alle già collaudate tecniche di realtime lighting (la quale gestisce il comportamento della luce diretta in tempo reale, senza però prenderne in considerazione gli effetti fisici) e di baked lightmaps (con la quale riusciamo a simulare il comportamento fisico della luce, ma in maniera precalcolata a limitata agli oggetti non animati), ma, riducendo e semplificando il lavoro degli sviluppatori, potrebbe garantire una libertà creativa finora irraggiungibile, mantenendo allo stesso tempo ferma l’idea che la creazione di un mondo finzionale ha bisogno sia di credibilità che di piacevolezza grafica.

In breve, possiamo affermare che la scelta artistica, quindi estetica e perché no etica, nello sviluppo e nell’intensificazione della grammatica visiva applicata e presente in un videogioco deve (o dovrebbe almeno) rimanere una priorità assoluta.

Ray tracing: un nuovo sguardo grazie alla luce?

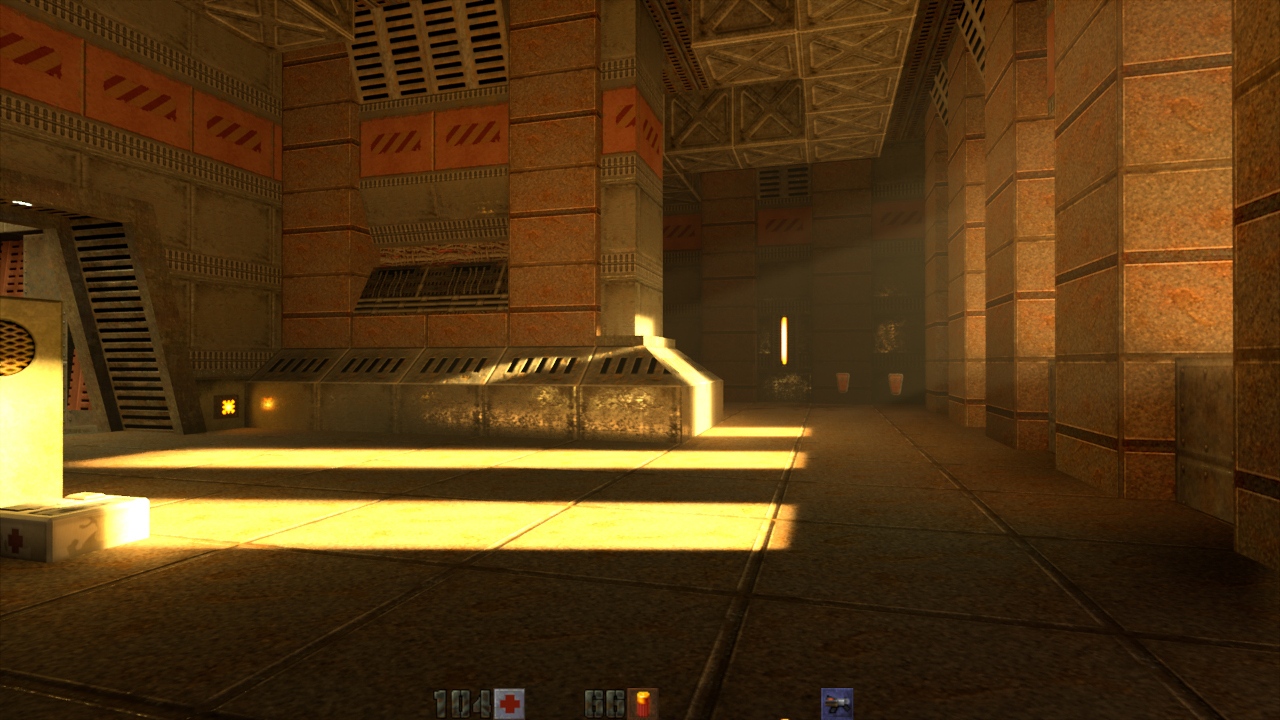

Accettato il compromesso tecnico che allontana il fotorealiasmo in tempo reale ancora di qualche anno, risulta comunque utile riflettere in merito ai mutamenti che un algoritmo automatizzato come il ray tracing (seppur nelle forme di una sua, quantitativamente parlando, limitata applicabilità) può avere per la percezione estetica delle immagini nei videogiochi a venire.

Senza dimenticare la sua, relativamente semplice, retroattività: letteralmente un gettare una nuova luce su cioè conosciamo; o almeno, che abbiamo conosciuto in un certo modo trasformandone la fisionomia, modificandone il ricordo e cambiandone il passato.

Perché se è vero che la forza di questa tecnica risiede tanto nella capacità di donare un comportamento fisico alla luce, quindi nel rendere più ricca e profonda la gamma di effetti visivi e la sua similarità con una realtà in cui la luce è colore, ombra, riflesso, scheggia opaca che si frappone o lamina traslucida che confonde, quanto nella rinnovata semplicità con cui tali risultano potranno essere raggiunti dai programmatori. È altresì importante sottolineare come, all’interno di questo nuovo dispositivo tecnologico incastonato nei corpi di silicio e nelle reti neurali delle GPU, risieda una specie di istintività informatica in grado (potenzialmente) di farsi racconto emozionale ed esperienziale nei suoi infiniti tentativi di riprodurre un’esistenza elaborata numericamente. Basti pensare alla differente carica espressiva che l’atmosfera di una stanza in penombra, di uno scorcio di tramonto o di una metropoli futuristica, senza parlare di un genere piuttosto che di un altro, potranno acquisire. Non si tratta di meglio o peggio, si tratta di avere esperienze concretamente differenti.

Ma anche di lasciare spazio a una nuova vita binaria e matematica che ora risponde a leggi pre-esistenti di questa realtà ma un domani chissà: non saremo solo noi videogiocatori, interagendo, a mutare sensibilità di fronte all’immersività aumentata dei futuri videogiochi, anche loro potrebbero reagire a noi sorprendendoci con quadri inattesi.

Possibili controindicazioni risiedono, come sempre, nell’eventuale appiattimento creativo e artistico che una produzione in serie, stile catena di montaggio, può portare.

Tutto sta nel saper dosare i mezzi a propria disposizione con il gusto per una ricercatezza stilistica che dovrà evitare di ridursi a mera dimostrazione di forza: “sempre” un mezzo per significare e mai fine vuoto.

Aumentare il “dettaglio” solo per far esplodere la complessità di un pensiero che non deve più sforzarsi di immaginare, è un impoverimento che il videogioco non deve permettersi. Nel frattempo, ci consoliamo sperando che il ray tracing possa costituirsi come un valore aggiunto e alternativo alla costruzione dei mondi immaginari che popolano questo medium.